Robots.txt là gì? Hướng dẫn tạo file Robots.txt chuẩn SEO

File robots.txt chính là một trong những yếu tố quan trọng trong quá trình tối ưu hóa SEO cho một website. Vậy file robots.txt là gì? Cách tạo file robots.txt chuẩn SEO như thế nào? Tham khảo bài viết dưới đây, SEO PLUS sẽ giúp các bạn giải đáp các thắc mắc này!

Nội dung chính

File robots.txt là gì?

Robots.txt là một trong những tập tin vô cùng quan trọng trong bộ cấu trúc website chuẩn SEO. Tập tin này cho phép bot của các công cụ tìm kiếm sẽ biết nên truy cập vào dữ liệu nào và không được phép truy cập vào dữ liệu nào. Từ đó. Việc lập chỉ mục của website sẽ trở nên chính xác hơn. Website của bạn cũng sẽ được index nhanh hơn.

Hiểu một cách đơn giản, file robots.txt là tập tin văn bản có đuôi .txt. Tệp này là một phần của Robots Exclusion Protocol (REP). Tệp này có chứa một nhóm các tiêu chuẩn quy định cách robots website hoặc robots của các công cụ tìm kiếm được thu thập dữ liệu ở đâu và cung cấp nội dung đó cho người dùng.

File robot.txt là gì?

Vì sao cần tối ưu file robots.txt?

Nếu bạn đã hiểu được cách hoạt động của các công cụ tìm kiếm thì các bạn sẽ hiểu rằng trong giai đoạn các bot đi thu thập thông tin và chỉ mục của website. Các công cụ tìm kiếm sẽ cố gắng tìm các trang có sẵn và công khai trên web, từ đó chúng có thể lập chỉ mục nhanh hơn. Nếu website bị thiếu file robots.txt thì các con Bot của trình duyệt tìm kiếm sẽ xâm nhập vào tất cả các trang và lập chỉ mục các trang đó. Điều này sẽ ảnh hưởng xấu đến việc SEO website và cả chất lượng của website nếu cấu trúc trang đó không được chuẩn.

File robots.txt sẽ giúp các bạn cho phép hoặc ngăn chặn các con bọ của công cụ tìm kiếm quét trên website của bạn. Nó còn ngăn chặn được các con bọ của những chương trình khác có thể quét mã nguồn trên website của bạn. Điển hình nhất là các chương trình HT Track Website Copier có thể copy website một cách tự động.

File robots.txt có tác dụng gì?

Như ở trên đã đề cập đến thì file robots.txt sẽ giúp ngăn các công cụ tìm kiếm có thể thu thập tất cả nội dung trên website của bạn để lập chỉ mục. Công dụng chính của file này sẽ được dùng trong các trường hợp cụ thể sau:

Chặn các công cụ tìm kiếm trong quá trình xây dựng website

Quá trình xây dựng và hoàn thiện website sẽ mất rất nhiều ngày. Thậm chí với những website có cấu trúc phức tạp thì thời gian kéo dài lên đến vài tuần, vài tháng. Do đó, trong quá trình này khi website chưa đưa lên chạy online và vẫn cần chỉnh sửa. Thì bạn sẽ không muốn Google Index các trang đang dang dở lúc này nên chặn tất cả các SE để không cho bot xâm nhập vào nội dung trang web đang phát triển. Sau này khi website đã hoàn thiện rồi thì bạn mới sửa file .txt và cho phép SE truy cập vào từng phần hoặc tất cả các nội dung theo mong muốn của bạn.

Ngăn chặn hành vi bị đối thủ chơi xấu

Khi sử dụng các công cụ tìm kiếm nhúng vào website của bạn. Trang kết quả sẽ có URL riêng và Google sẽ index các trang đó. Và điều tệ hại là các đối thủ của bạn có thể lợi dụng tính năng đó để cố tình search những từ khóa có nội dung xấu hoặc nhạy cảm để gây bất lợi cho website của bạn. Vì thế, việc sử dụng file robots.txt chính là cách phòng tránh và chặn toàn bộ trang kết quả. Không cho các SE có thể vào index hay đánh giá website của bạn.

Chặn các công cụ thu thập liên kết như Ahrefs

Các công cụ thu nhập liên kết như Ahrefs sẽ dùng các con bọ để thu thập thông tin trên website của bạn như: Backlinks, Referring domains, Organic keywords, top pages…Bạn có thể sử dụng công cụ này để chặn công cụ ahref không cho đối thủ phân tích website của bạn nhằm bắt chước hoặc cạnh tranh seo từ khóa trực tiếp với bạn nếu như từ khóa đang nằm trong Top. Để các bạn có thể ngăn chặn được các mối nguy hiểm này thì bạn có cách đơn giản nhất đấy là dùng file robots.txt đặt một đoạn mã để block các con bọ này.

Hướng dẫn cách tạo file robots.txt chuẩn SEO

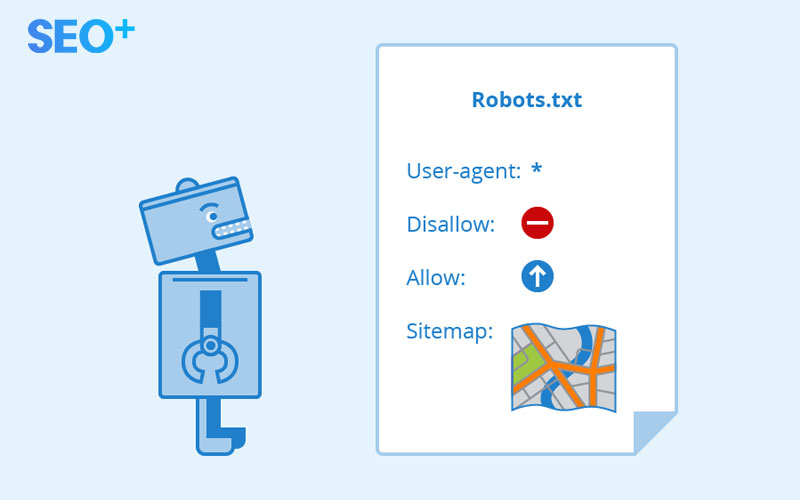

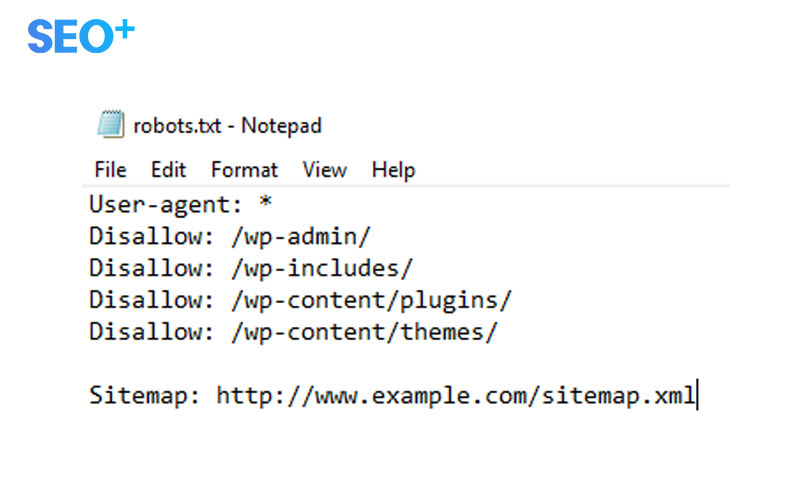

Để có thể tạo được một file robots.txt chuẩn SEO, các bạn cần nắm được cấu trúc của một tệp robots.txt khi hiển thị như thế nào. Dưới đây là hình minh họa cấu trúc chuẩn:

Ý nghĩa của các thuật ngữ trong file robots.txt

- User – agent chính là tên của các bot trên các trình duyệt tìm kiếm có tác dụng thu thập dữ liệu.

- Disallow chính là dòng thông báo cho các User – agent biết rằng không được thu thập dữ liệu URL cụ thể nào. Mỗi URL chỉ được phép có 1 dòng Disallow.

- Allow chính là dòng lệnh cho phép các User – agent được phép truy cập vào trang nào, URL nào.

- Crawl – delay chính là dòng lệnh thông báo cho các trình thu thập thông tin với số thời gian phải chờ trước khi muốn tải và thu thập nội dung trên website.

- Sitemap chính là dòng lệnh giúp cung cấp các vị trí của URL trong sitemap website.

Tiếp đến, bạn bắt đầu kiểm tra xem website của mình có tệp file robots.txt hay không. Nếu chưa có các bạn có thể tạo file robots.txt đơn giản theo cách sau đây:

- Bạn chỉ cần dùng công cụ Notepad của Windows. Sau đó, bạn mở 1 tệp mới rồi đặt tên là robots.txt rồi ghi lại như vậy đã xong phần khởi tạo tệp.

- Các bạn sử dụng cú pháp tiêu chuẩn của file robots.txt như chúng tôi đã giới thiệu ở trên.

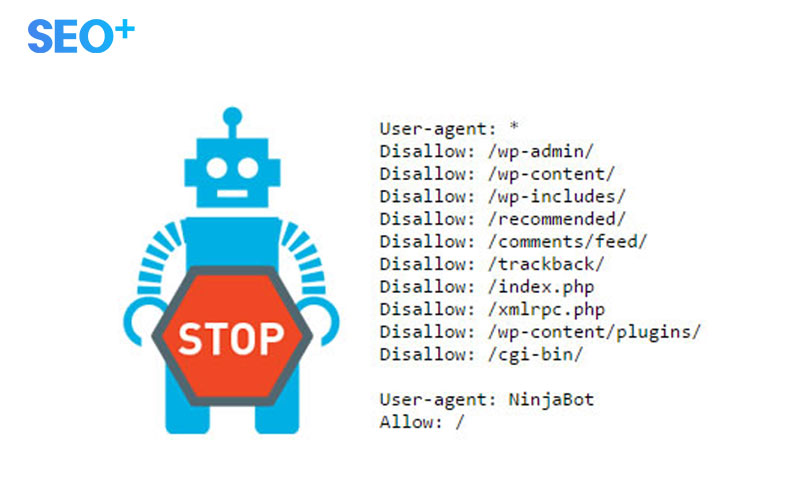

Ví dụ của 1 file robots.txt sẽ bao gồm

- User – agent: Tên loại bot

- Disalow: Tên file không cho phép bot có tên trong User – agent có thể truy cập vào.

- Allow: Tên file cho phép bot User – agent có thể truy cập được.

Khi tùy chỉnh file robots.txt, cần lưu ý những vấn đề sau:

- Câu lệnh cần phải được viết chính xác, không thiếu hay thừa ký tự, giữa các ký tự không được có khoảng trắng, không phân biệt chữa hoa và chữ thường.

- File phải được lưu theo bảng mã utf-8 không sử dụng mã Unicode vì sẽ làm ảnh hưởng đến việc hiển thị ra các ký tự không đúng như mong muốn.

Tạm kết:

Trên đây, SEOPLUS đã giới thiệu đến các bạn chi tiết vềkhái niệm file robots.txt cùng tác dụng trong SEO. Hy vọng với những thông tin chúng tôi cung cấp trên đây sẽ giúp bạn tối ưu website hiệu quả. Để giúp website của bạn cảu thiện được thứ hạn trừ khóa trên công cụ tìm kiếm, SEOPLUS cung cấp dịch vụ SEO website bao gồm:

Với những gói dịch vụ chuyên nghiệp trên đây, chỉ từ 4 – 6 tháng website của bạn sẽ tăng trưởng 200% về lượng traffic cũng như chuyển đổi!